データセンター冷却技術の最前線を解説

河内 海斗:2023年IIJに入社し、データセンターサービスの設計・開発に従事。AI向けインフラや高密度サーバ、冷却技術など目まぐるしく進展する技術、また環境負荷低減の要請に応えるべく、サービス開発に取り組む。現在はとくに液冷技術関連を担当し、市場リサーチから企画、開発まで幅広く携わる。

平川 一貴:データセンターサービスの企画から、運用マネジメント、導入支援や技術サポート業務など幅広く担当。長年、DCビジネスに携わり蓄積してきた実践的ノウハウと、DCファシリティの運用者視点を強みとする。

執筆・監修者ページ/掲載記事:1件

データセンターの需要が急速に高まる中、注目を集めているのがデータセンターの冷却技術です。本記事では、データセンターにおける冷却設備の役割や技術的な進化、そして現在注目される理由を解説します。データセンターを利用中、また利用をご検討中の企業様にとって参考となる情報をご紹介します。

- 目次

データセンターにおける冷却設備の役割と重要性

データセンターは、サーバやネットワーク機器を安全かつ効率的に運用するための専用施設です。データセンター内部には、これらの機器を収納するラックスペースのほか、大容量の電源設備、高速通信回線などが整備されています。その中でも機器の発熱対策を行う冷却設備は、データセンターの安定稼働を支える上で欠かせない存在です。

冷却設備は、稼働中に大量の熱を発生するデータセンターのサーバやネットワーク機器を冷やし、温度上昇を抑えるという重要な役割を担っています。適切な温度管理が行われない場合、機器の性能低下や故障を引き起こし、サービス停止やデータ損失といった安定稼働を脅かす重大なトラブルにつながる可能性があります。

24時間365日稼働が求められるデータセンターでは、冷却設備にも高い信頼性や冗長性等が求められます。冷却設備の設計・運用は、データセンター全体の信頼性やサービス品質を左右する重要な要素なのです。

データセンター冷却方式の主流は「空冷方式」

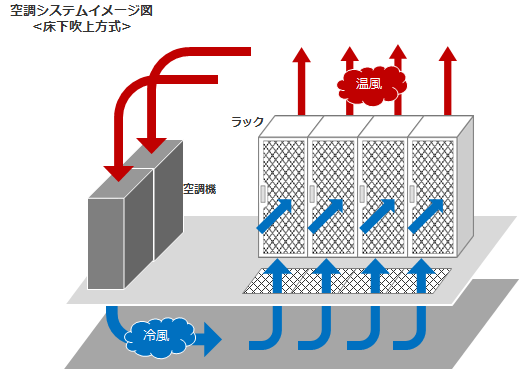

データセンターの冷却方式にはいくつかの種類がありますが、現在、主流となっているのは「空冷方式」です。空冷方式は、サーバルーム内に冷却された空気を循環させることで、機器の温度を下げる仕組みです。導入コストが比較的低く、空気での冷却による安定稼働に適した技術として、データセンターの標準的な冷却方式として長年にわたり広く採用されてきました。

空冷方式による冷却イメージ

空冷方式にもいくつかの実現方法や仕様があり、

本図は一例をイメージ化したものです

しかし近年、サーバの高性能化・高密度化が進み、空冷方式だけでは十分な冷却が難しくなるケースが増えています。特に、AIなどの高度な処理を支えるため、CPUやGPUの性能が向上し、発熱量が増加しています。同時に1ラックあたりに搭載するGPUサーバ等の機器数も増加しています。その結果、空冷方式に代わる新たな技術が求められています。

また、省エネや再生可能エネルギーの活用など、エネルギー消費に対する世界的な取り組みも、冷却技術の見直しを促しています。空冷方式は一般的に大量の空気を循環させるためにファンや空調設備を稼働させる必要があり、その分電力消費が大きくなります。冷却効率が低いと、サーバの安定稼働に余分な電力が必要となり、結果的にエネルギー効率が悪化します。

データセンターにおけるエネルギー効率の向上は喫緊の課題であり、日本政府は「グリーン成長戦略」において、2030年までに新設データセンターの30%を省エネ化、2040年までにカーボンニュートラルの達成を目標に掲げています(※1)。こうした政策的な要請も、冷却効率の高い新たな冷却技術の開発を後押ししています。

(※1)出典:2050年カーボンニュートラルに伴うグリーン成長戦略(経済産業省)

新たな選択肢「液冷方式」とは

空冷方式の課題に対応するため、新たな選択肢として注目されているのが「液冷方式(Liquid Cooling)」です。空気よりも熱伝導率の高い水や油などの液体を用いる液冷方式は、空冷方式に比べ効率的に熱を除去することができる冷却手法です。日本国内では「水冷方式」と呼ばれることもあります。

従来の空冷方式ではサーバラックあたり約20kWの冷却が限界といわれています。しかし、昨今の高負荷サーバはサーバラックあたり約100kWの冷却が必要となる場合があります。実際にGPUチップ開発の最先端を走るNVIDIA社が提供しているGB200 NVL72というラックスケールのアーキテクチャでは、サーバラックあたり約132kWの冷却能力が必要です。こうした高負荷サーバに対応する冷却技術として、様々な企業が液冷方式の実証実験やサービス化を進めています。

高負荷サーバの中でも、特にGPUを用いたサーバは近年急激に性能が進化しており、チップメーカやサーバメーカは新たな製品を次々と発表しています。2025年10月に行われた「OCP Global Summit」では、サーバラックあたり480kWのアーキテクチャが発表され(※2)、更に今後1MWクラスも展開される可能性が発信されました(※3)。こうした背景から、今後液冷方式の重要性は更に増していくことが考えられます。

液冷方式には、「Direct-to-chip」と「Immersion」があります。国内では「Direct-to-chip」を「Direct Liquid Cooling(DLC)」、「Immersion Cooling」を「液浸冷却」と呼ぶことが多いため、本記事では「Direct Liquid Cooling(DLC)」と「液浸冷却」の名称を用います。

- Direct Liquid Cooling(DLC):水配管やコールドプレート(冷却プレート)などに冷却液を通すことで、コールドプレートを介してGPUチップ等の熱を交換させる方式

- 液浸冷却:サーバ基板すべてに冷却液を直接接触させ、熱を効率的に吸収する方式

次の章では、それぞれの特徴を解説します。

(※2)「NVIDIA GB200 NVL72 Super Cluster AIデータセンター向けエンドツーエンド液冷ソリューション(PDF)」(スーパーマイクロ株式会社、2024年10月)

(※3)「Scaling Data Center Infrastructure(Ihab Tarazi、Dell Technologies)」(2025 OCP Global Summit)

「Building Zettascale AI Clusters with OCI: Scaling Together with Open Ecosystem for the Next-Gen AI(Pradeep Vincent、Oracle)」(2025 OCP Global Summit)

液冷方式の1つ「Direct Liquid Cooling(DLC)」

DLCは、GPUやCPUのチップ上にコールドプレートを組み込み、局所的に液体を用いた冷却をするのが特徴です。

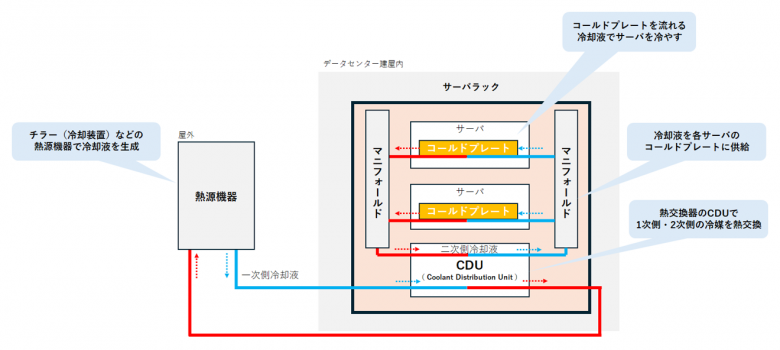

「DLC」の構成と仕組み

一般的にDLCにおける設備には、サーバラック外では熱源(チラー等)、水配管、ポンプ、継手、熱交換を担うCDU(Coolant Distribution Unit、冷却液分配ユニット/熱交換器)などがあります。サーバラック内にも各サーバに液体を送りこむマニフォールド、ホース、コールドプレート(液冷対応サーバ)などの設備が必要です。CDUはサーバラックの外に設置するインロー型と、サーバラック内に設置するインラック型があります。

冷却液の経路としては、チラーやドライクーラ等の熱源で液体を冷却し、水配管を通じてサーバ室に設置されるCDUに供給されます。CDUからはサーバラックに設置されるマニフォールドに流れ、各サーバのコールドプレートに供給されます。コールドプレートからは逆の経路で熱源まで還り、このような経路で冷却液が循環し、コールドプレートで熱を吸収した液体を熱源で冷却している構成となっています。

DLCの導入にあたっては、新たな設備の設置と、運用・メンテナンス体制の整備が必要です。いずれにも、データセンター特有の環境条件や高い冗長性を考慮した設計が求められます。以下では、DLCを支える主要設備とその導入の留意点、そして運用・メンテナンスの要点について詳しく解説します。

「DLC」の主な設備

●熱源機器

冷却液を生成し、CDUへ供給します。熱源にもいくつか種類があるため、生成する冷却液の温度帯や省エネ性、導入・運用コストなどを考慮して適切に選定する必要があります。また、既存のデータセンターに液冷方式を新たに構築する場合は、熱源の設置スペースなどの考慮も非常に重要となってきます。更に、熱源機器からサーバ室などに冷却液を送るための水配管スペースの確保なども考慮が必要です。

熱源機器の製品例

桑名金属工業株式会社「チルドタワー®」CTS-A075M(「チルドタワー®」は桑名金属工業の登録商標)。ドライクーラとチラーが一体となった製品。ドライクーラの機能により外気を利用した冷却が可能なため、外気温が低い時期や夜間などの電力消費を抑える仕組みを備える。

●CDU

CDUは一次側と二次側の冷却液を熱交換し、温度や流量などを制御する液冷設備の構成の中でも非常に重要な役割を担っています。CDUは大きく2種類あり、インロー型とインラック型があります。

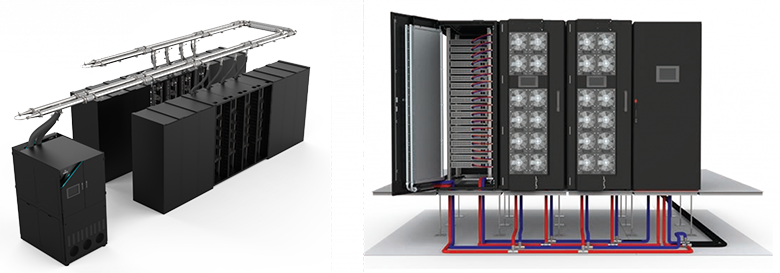

- インロー型:サーバラック程度の大きさ。冷却能力が非常に高く(500kWや1,000kW超など)、架列単位での制御などに使用。サーバ室に設置する場合や、隣接する機械室に設置する場合など、限られたスペースを有効に使うことが重要になる

- インラック型:サーバ機器程度の大きさ。冷却能力は70kWや200kW超などで、主にサーバラックごとの制御などに使用

CDUは現在様々なメーカで製造されており、CDU内部で配管やポンプ、フィルターなどが冗長化されているものもあり、万が一重要なパーツが故障した際にもシステムを止めずに交換することが可能な製品もあります。

CDUの製品例

左:インロー型CDU(nVent社 RowBasedCDU CX121)、

右:インラック型CDU(nVent社 Rack Based CDUs CZ61(AC Power)、CZ62(DC Power))

●マニフォールド

サーバラック内に設置され、液体を各サーバに分配する役割を担っています。マニフォールドは最低でも約42Uサイズの高さで直径50mm程度のスペースが必要となるため、従来のサーバラックサイズには収まらない可能性があります。昨今ではサーバラックサイズを大きくして納めるか、従来サイズのサーバラックに拡張用のフレームを取り付けてマニフォールドを設置する方法が採用されています。

なお、マニフォールドのサーバラックへ分配する接手部には、OCP(The Open Compute Project)の規格であるUQD(Universal Quick Disconnect)に基づいたカプラー(接続部品)が一般的に使用されています。これはワンタッチで継手の着脱ができ、着脱時の漏水防止機構が設けられているため、迅速かつ信頼性の高い着脱作業が行えます。

マニフォールドの製品と搭載例

左:マニフォールド(nVent社 RACKCHILLER RACK MANIFOLD)、

右:マニフォールド搭載例(nVent社 RACK MANIFOLD搭載例)

●冷却液

冷却液には、水よりも化学的に安定しているプロピレングリコールを約25%含む水溶液であるPG25が多く用いられます。しかし、PG25は容器等に入った状態で用意されることが多く、系統全体で使用することはコストや作業性の観点で非現実的です。そのため、主に使用される個所としてはCDU2次側以降の系統が多いです。

PG25は熱伝導率や比熱容量などが一般的な水と同等性能で、加えて防錆・防食性が高く腐食リスクが低い液体と言われています。CDU一次側では、チラー等から熱源機器から送られる冷却液として、主には水道水が使用されます。このとき、水道水をそのまま使用する場合は腐食リスクなどを伴う可能性があるため、センサーの導入や水質検査機関への委託などを実施して冷却液の水質を確認し、適切な水質を維持する必要があります。ASHRAE(American Society of Heating, Refrigerating and Air-Conditioning Engineers、アメリカ暖房冷凍空調学会)のドキュメント(※4)でも必要な水質を定めており、CDUの要求水質などにも用いられています。

(※4)「Water-Cooled Servers Common Designs, Components, and Processes(PDF)」(ASHRAE、2019)

●水配管

サーバ室内に敷設する水配管は、大きく2通りの敷設方法があります。

1つは天井から吊り下げてサーバ室上部に敷設する方法です。イメージとしてはケーブルラックを吊り下げているのと似たような形です。この方法は主に欧米諸国のデータセンターで採用され、よく「上配管」という呼び方をします。2つめはサーバ室にフリーアクセスフロアを設けて、その下に水配管を敷設する方法です。この方法は主にアジア圏のデータセンターで採用されています。こちらはよく「下配管」という呼び方をします。

どちらも一長一短ではありますが、日本では下配管で検討するケースが多いです。これは漏水に関するリスク軽減の考えからきています。上配管で漏水してしまったら、漏水規模によってはサーバ機器に液体が付着するリスクが非常に高まり、加えて付近に電気設備や通信設備などがある場合は更に影響を及ぼすことが考えられます。対して、下配管の場合はフリーアクセスフロア内で収まり、サーバ機器等に液体が付着するリスクは低いと考えられます。しかし、下配管の場合はメンテナンスや点検の作業性、フリーアクセスフロアの構築、水配管による床への荷重などデメリットも存在します。

欧米諸国で上配管が多く採用されている理由としては、下配管のデメリット解消に加えて消火設備の仕様があると考えられます。一般的な消火設備として、日本はガスによる消火を採用していますが、欧米ではスプリンクラーによる水消火を採用しています。スプリンクラーが既に設置されていることが一般的である場合、液冷設備の有無に関わらず上配管のリスクを受容しているため、効率的と考えられる上配管を採用していると推測されます。

当然、日本でも上配管で構築しているデータセンターもあれば、欧米でも下配管で構築しているデータセンターは存在するため、各データセンターの設計で総合的に考えていることでしょう。

上・下配管の製品例

左:上配管(nVent社 nVent Technology Cooling System(TCS)Manifolds)、

右:下配管(nVent社 TCS Manifoldsイメージ)

導入と運用・メンテナンスの留意点

①導入時:空冷方式との併用が必要

DLCの設備を導入するにあたっては従来の空冷方式も同時に必要です。これはサーバ内基板のコールドプレート部分以外で発熱するパーツや液冷対応していないネットワーク機器等の冷却に空冷が不可欠だからです。そのため、従来から採用されてきた空冷方式と液冷方式はハイブリッドで構成する必要があります。

空冷方式で必要な冷却能力として、液冷方式と空冷方式の比率は7:3とよくいわれています。例えば、1つのサーバラックに必要な冷却能力が50kWの場合は15kWの冷却能力が必要ということです。ただし、サーバ機器やサーバラックに搭載される機器構成などで変化するため、具体的な数値については都度確認が必要です。

②運用・メンテナンス:特有の環境に対応する仕組みと体制が必要

24時間365日稼働させなければならないデータセンターにおいては、液冷機器等のメンテナンスや漏水時のオペレーションなど、DLCに対応する運用・メンテナンスの仕組み、体制も不可欠です。

空冷方式のデータセンターでは、契約条件やデータセンター利用ルール等でサーバ室に液体を持ち込むことは禁止されていることが一般的です。これはサーバ機器などに万が一液体が付着して故障するリスクを避けるためです。しかし、液冷方式の設備が採用されるとサーバ室内で液体が使用されることになります。

そのため、データセンター事業者や利用者は液体が漏れないように、水配管やホース、CDU等を定期的にメンテナンスする必要があります。従来でも電気設備やサーバ機器等に関するメンテナンスは定期的に実施してきましたが、新たに液冷設備に関するメンテナンスも加わるため、その計画の立案や技能の習得、点検時間の確保などが必要になります。また、サーバ機器等の天敵である液体を取り扱うため、より一層の注意が求められます。

しかし、メンテナンスや設備の監視を日々注意深く実施していても、漏水の可能性を100%取り除くことは難しいです。そのため、運用では万が一漏水が発生してしまったときのオペレーションを事前に考えておかなければなりません。液体付着による機器故障リスクを下げるため、漏水箇所の特定、影響範囲の確認、止水処置の対応、漏水した液体の除去等を迅速かつ的確に行う必要があり、手順の策定や訓練などを運用開始前に実施することが重要です。

また、サーバ室への液体持ち込みに関するルールについても、冷却液を用いることとなるため、改める必要があります。

もう1つの液冷方式「液浸冷却」

コールドプレートを介して冷却するDLCに対して、サーバの発熱部分に冷却液を直接接触させる方法が液浸冷却です。この方式は、サーバ本体などIT機器を冷却液に完全に浸すことで冷却します。冷却効率が高く、消費電力の削減にも大きく貢献するため、コールドプレートを用いたDLCと同じく、新たな選択肢として注目されています。

DLCと同様、導入に際しては、新たな設備や運用・メンテナンスが必要です。例えば、液浸冷却では、一般的には従来のサーバラックは使用することができず、液浸装置などの専用設備の導入が必要となります。

また、代表的な運用課題としてよく挙げられるのはサーバのメンテナンスです。液浸冷却の場合は、基板を冷却液に浸すことで冷却していますが、保守メンテナンス等でサーバ機器に触れる場合、サーバを停止して冷却液から引き上げる必要があります。その際にはサーバを引き上げるための装置などを用意する必要があります。また、引き上げた際にも基板に付着している冷却液が完全に落ちきるまで待機するなどの手間も発生します(最近では揮発性の高い液体なども開発されてきています)。また、同じ床面積で比較した場合、サーバラックよりも液浸装置では、搭載できるサーバは従来のサーバラックより少なくなってしまうなどの課題も存在します。

ほかにも、液浸対応の専用サーバが必要になったり、液浸装置内では一般的な光ケーブルが使用できなかったり、様々な課題があります。

しかし、新たな冷却液や液浸装置の開発も進んでいるほか、データセンター業界以外からの新規参入もみられるなど、市場は活発化しています。更に、NVIDIA社ではDLCと液浸冷却の技術を融合させたGPUサーバの開発も進められており、今後需要が高まる可能性も予想されます。

IIJにおけるデータセンター冷却技術の取り組み

IIJもこの冷却方式に着目し、次世代のデータセンターに向けた取り組みを進めています。

2025年5月には、AI用途のGPU搭載サーバに代表される発熱量が著しく高いIT機器の収容が可能な白井データセンターキャンパス第3期棟の増設を発表し、2026年度中の運用開始を予定しています。また、白井データセンターキャンパス3期棟は液冷方式に必要な専用熱源の設置スペース、熱源からサーバ室内までの水配管ルートをあらかじめ確保した「水冷Ready設計」を採用しています(※5)。

白井データセンターキャンパス

3期棟イメージ

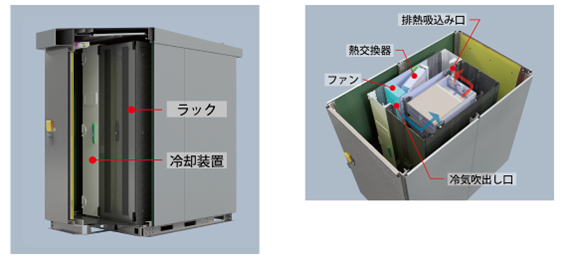

また、AI向けのGPU搭載サーバにも対応する電力供給能力と高効率なサーバ冷却機能を備えたモジュール型エッジデータセンター(1モジュールあたり最大45kWの電力供給能力)の開発を進めています。モジュール型エッジデータセンターは河村電器産業との共同開発によるもので、2025年度下半期の製品化を目指しています(※6)。

モジュール型エッジデータセンター試作イメージ

そのほかにも、経済産業省、NEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)の委託を受けたAI時代向けデータセンターの研究開発にも取り組んでいます。本研究で得られたノウハウを活かしながら、液冷に関する幅広いニーズに対応できるようなサービス提供の準備も進めています(※7)。

ITの進展やお客様のニーズに応えていくため、IIJでは今後もこうした技術革新を通じて、高品質で持続可能なデータセンターサービスの提供を目指してまいります。

(※5)「IIJ、自社サービス需要拡大に対応し「白井データセンターキャンパス」3期棟を増設」(2025年5月8日)

(※6)「IIJと河村電器産業、AI用GPU搭載サーバも収容可能なモジュール型エッジデータセンターを共同開発」(2025年3月11日、株式会社インターネットイニシアティブ、河村電器産業株式会社)

(※7)「直接水冷方式の高密度AIサーバおよびハイブリッド冷却データセンターによる超高効率AI計算基盤技術の実証実験を開始」(2025年9月11日、株式会社Preferred Networks、株式会社インターネットイニシアティブ、国立大学法人北陸先端科学技術大学院大学)

気になることがあればお気軽に

- 前の記事

- 次の記事

![エンタープライズIT [COLUMNS]](https://ent.iij.ad.jp/wp-content/themes/liquid-smart-child/img/logo.svg)